Digitalisierung von Bildern

Beim Fotografieren eines Objekts gelangt Licht durch die Linse der Kamera und fällt auf den 'Sensor'. Hier erfolgt an verschiedenen Punkten eine Messung. Jeder Messpunkt kann einen anderen Wert haben. Zwischen den Messpunkten gibt es keine weiteren Werte. Da die Messpunkte wie in einem Raster angeordnet sind, spricht man von Rasterung. Je mehr Messpunkte ein Kamerasensor hat, desto eher entspricht das aufgenommene Bild dem realen Bild.

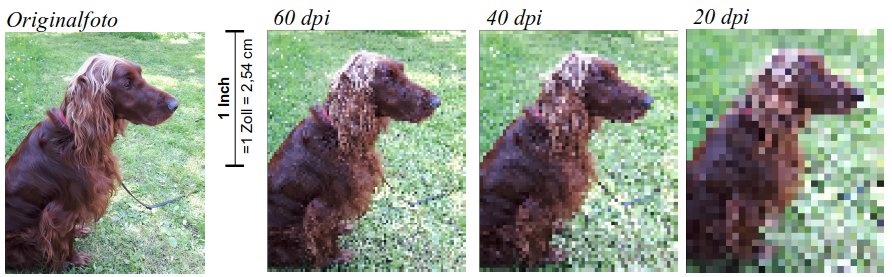

Die Bildauflösung wird gemessen in dpi (dots per inch, also: Pixel je Inch). Gelegentlich wird die Bildauflösung auch in MP (MegaPixel) angegeben und bezeichnet die Gesamtzahl der Pixel.

Bildquelle: M. Klein - ZPG IMP

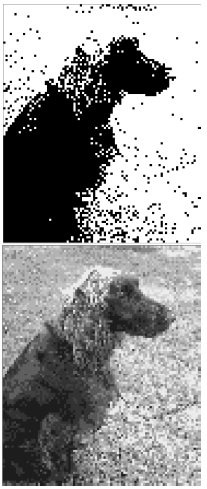

Bildquelle: M. Klein - ZPG IMP

Was wird von einem Messpunkt gemessen? Ein einfacher Sensor kann z.B. nur Hell und Dunkel unterscheiden. Das Bild sähe (bei 60 dpi) dann wie rechts aus. Ein besserer Sensor kann z.B. 16 verschiedene Grauwerte unterscheiden (rechts unten), und ein noch feinerer Sensor kann z.B. ca. 16,8 Millionen verschiedene Farben unterscheiden (oben).

Ein Sensor, der 16 verschiedene Farben unterscheiden kann, benötigt zum Darstellen der 16 Farben 4 Bit (weil 24 = 16 ist). Die Farbtiefe beträgt hier also 4 Bit. Eine Handykamera mit z.B. 24 Bit Farbtiefe hat für jede einzelne Farbinformation 24 Bit zur Verfügung. Damit können 224 = 16.777.216 verschiedene Zahlen, also Farben, dargestellt werden.

Einen einzelnen Rasterpunkt nennt man auch Pixel. Wenn ein Bild in ein vorgegebenes Raster übertragen wird, so nennt man diesen Vorgang Diskretisierung.

Was umgangssprachlich als ein Kamerasensor bezeichnet wird, besteht physikalisch gesehen aus sehr vielen Sensoren. Je Messpunkt gibt es gleich mehrere Sensoren, nämlich für Helligkeit, Rot-, Blau- und Grün-Anteil.

Datenmenge / benötigter Speicherplatz

Die Datenmenge eines Bildes ergibt sich aus der Gesamtzahl der Pixel, sowie der Farbtiefe, also dem Speicherplatz, den man für die Farbinformation eines einzelnen Pixels benötigt.

Aufgabe:

-

Ergänze: Die ____________ eines Bildes wird bestimmt durch Bildauflösung und Farbtiefe. Die _________________ bestimmt, wie grob oder fein das Raster ist, in das das Bild übertragen wird. Je feiner das Raster, desto besser ist die Auflösung und damit die Qualität der Aufnahme. Je ___________ Pixel pro Inch das Bild hat, desto _____________ ist dessen Auflösung.

Die ____________________ ist der Speicherplatz, der benötigt wird, um die Farbinformation für ein Pixel zu speichern. Sie bestimmt also, wie viele verschiedene Farben je Pixel möglich sind.

-

-

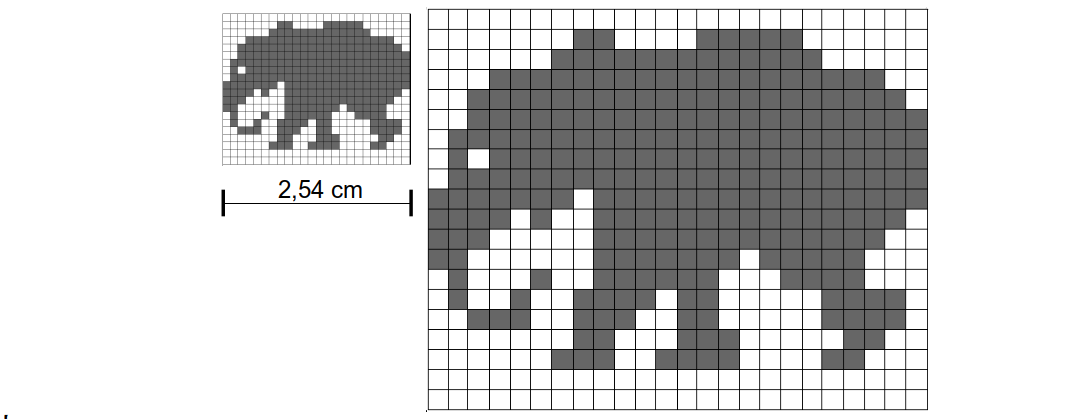

Gib die Bildauflösung der beiden Elefanten-Bilder in dpi an.

-

Gib für beide Bilder auch die Gesamtzahl der Pixel an.

-

Berechne die Datenmenge des Elefanten-Bildes. (Betrachte nur die reinen Bilddaten.)

-

-

Beschreibe allgemein, wie man den Speicherplatz eines Bildes berechnen kann. Erstelle dazu eine Formel.

-

Berechne die Datenmenge des Hundefotos bei einer Bildauflösung von 60 dpi

als Schwarzweiß-Bild,

als Graustufen-Bild mit 16 Farben,

als Farbbild (Handyfoto).

-

Im Original hat das Hundefoto eine Größe von 3209 x 2649 Pixel und eine Farbtiefe von 24 Bit. Berechne die Datenmenge.

-

Recherchiere die Bildauflösung von

- Druckern (Laserdrucker, Tintenstrahldrucker)

- Bildschirm / Fernseher

- Handykamera / Vollformatspiegelreflexkamera

- einem Foto in bester Qualität

- weiteren

-

Betrachte das Schwarzweiß-Bild mit dem Elefanten. Wie könnte man Speicherplatz sparen?

Digitalisierung von Bildern: Herunterladen [odt][3 MB]

Digitalisierung von Bildern: Herunterladen [pdf][591 KB]

Digitalisierung von Bildern - Darstellungsformate: Herunterladen [odt][166 KB]

Digitalisierung von Bildern - Darstellungsformate: Herunterladen [pdf][214 KB]

Weiter zu Portable Bitmap