Vorwort

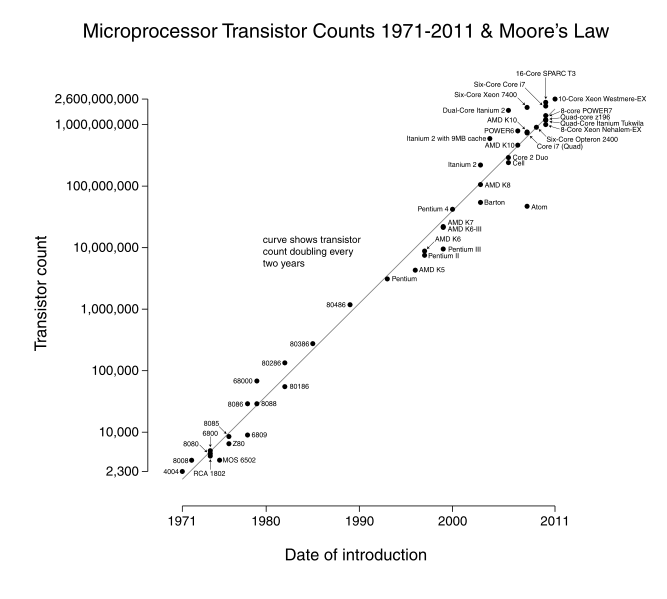

Transistorenanzahl, Transistor_Count_and_Moore's_Law_-_2011.svg von Wgsimon [CC BY-SA 3.0] via Wikimedia Commons

Jedes Jahr kommen neue Computermodelle auf den Markt, die noch schneller, noch leistungsfähiger sind als das Vorgängermodell. Neue Spiele benötigen immer bessere Grafikkarten. Schon das Betriebssystem ist so umfangreich, dass man unter 8 GB Arbeitsspeicher gar nicht mehr anfangen muss. Schon 1965 ging Gordon Moore von einer Verdopplung der Leistungsfähigkeit alle ein bis zwei Jahre aus (er nahm als Maß die Anzahl der Transistoren pro Flächeneinheit). Dieses „Moorsche Gesetz“ gilt erstaunlicherweise heute immer noch.

Ist es da überhaupt möglich ein über mehrere Jahre oder gar Jahrzehnte beständiges Grundkonzept des Aufbaus eines Computers zu erlernen? Überraschenderweise kann diese Frage ganz klar mit „Ja“ beantwortet werden. Schon im Jahr 1945 hat John von Neumann eine Rechnerarchitektur vorgeschlagen, die im Grundprinzip bis heute Bestand hat, obwohl zu dieser Zeit die ersten Computer noch in der Entwicklung waren. Diese über Jahrzehnte gültige Rechnerarchitektur erlaubt es uns, das Thema „Hardware“ im Informatikunterricht zu behandeln, ohne auf die ständig wechselnden Einzelheiten eingehen zu müssen.

Um das komplexe Thema „Funktionsweise eines Computers“ zu strukturieren, biete es sich an, das Schichtenmodell als Grundlage zu nehmen, das auch bei der Entwicklung neuer Computer und Software von Bedeutung ist. Kein Mensch kennt sich heutzutage in allen Schichten perfekt aus. Durch die Kapselung der Funktionalität müssen die Entwickler immer nur wissen, wie die direkt darunter liegende Schicht benutzt werden muss. Beim Schreiben von Anwendungsprogrammen kennt der Programmierer beispielsweise nur die Befehle der Programmiersprache, macht sich aber keine Gedanken darüber, wie diese in Transistorschaltungen umgesetzt werden.

| Schicht | Erläuterung |

|---|---|

| 6. Anwendung |

Der Programmierer einer Anwendung verwendet eine Hochsprache, die ihm erspart, genauere Kenntnisse über das zugrundeliegende Betriebssystem zu haben. Die Entwickler solcher Programmiersprachen benötigen dagegen sehr genau Kenntnisse bezüglich der Funktionsweise des Betriebssystems. |

| 5. Betriebssystem |

Die Entwickler eines Betriebssystems müssen anfangs zunächst unzählige Funktionen und Schnittstellen (APIs) zur Verfügung stellen. Dann müssen sie den Hardware-Firmen die Standards mitteilen, damit diese dann entsprechende „Treiber“ entwickeln können. Bei Linux ist es allerdings häufig umgekehrt: Die Hardware-Firmen teilen im günstigsten Fall den Entwicklern die Hardware-Schnittstellen und deren Standards mit und überlassen es den Betriebssystem-Entwicklern, passende Treiber zu schreiben. |

| 4. Architektur | In dieser Schicht wird der Datenaustausch der Hardware-Komponenten festgelegt. Je nach Lesart gibt es heute 3 bzw. 4 verschiedene Architekturen. Die hier vorgestellte von-Neumann-Architektur ist eine von ihnen. |

| 3. Logische Ebene |

Das Zusammenschalten der Elemente aus der zweiten Ebene (Transistor, CMOS, ...) kann man mit logischen Funktionen, also mathematisch beschreiben. Das entsprechende Teilgebiet der Mathematik heißt Schaltalgebra oder Boolesche Algebra. Hier werden auch Schaltungen für die Grundrechenarten beschrieben. |

| 2. Elektrische Ebene | Diese Ebene beschreibt die tiefste Ebene der Hardware. Es geht um Transistoren und elektronische Schaltkreise. |

| 1. Physikalische Ebene | Hier geht es ganz elementar um Gesetze der Physik, die den elektrischen Strom und die elektrische Spannung in einfachen oder auch komplexen Schaltkreisen betreffen |

Nach einem kurzen Überblick über die historische Entwicklung der Architektur der Rechenmaschinen (Schicht 4), werden in den folgenden Kapiteln diese Schichten ausgehend von der elektrischen Ebene (Schicht 2) bis hoch zur Ebene der Anwendungsprogrammierung (Schicht 6) behandelt.

Hintergrundinformationen: Herunterladen [odt][4 MB]